PR12 Season4 정리

1.PR-377: Scaling Up Your Kernels to 31x31: Revisiting Large Kernel Design in CNNs

이 논문을 한마디로 설명하자면 CNN에서 convolution filter를 키워서 large receptive filed를 잘 설계하는 논문입니다.왜 ViT의 성능이 좋았나?최근 ViTs를 CNN으로 대체할 수 있다는 논문들이 많이 나오고 있습니다. 이전에 ViT가

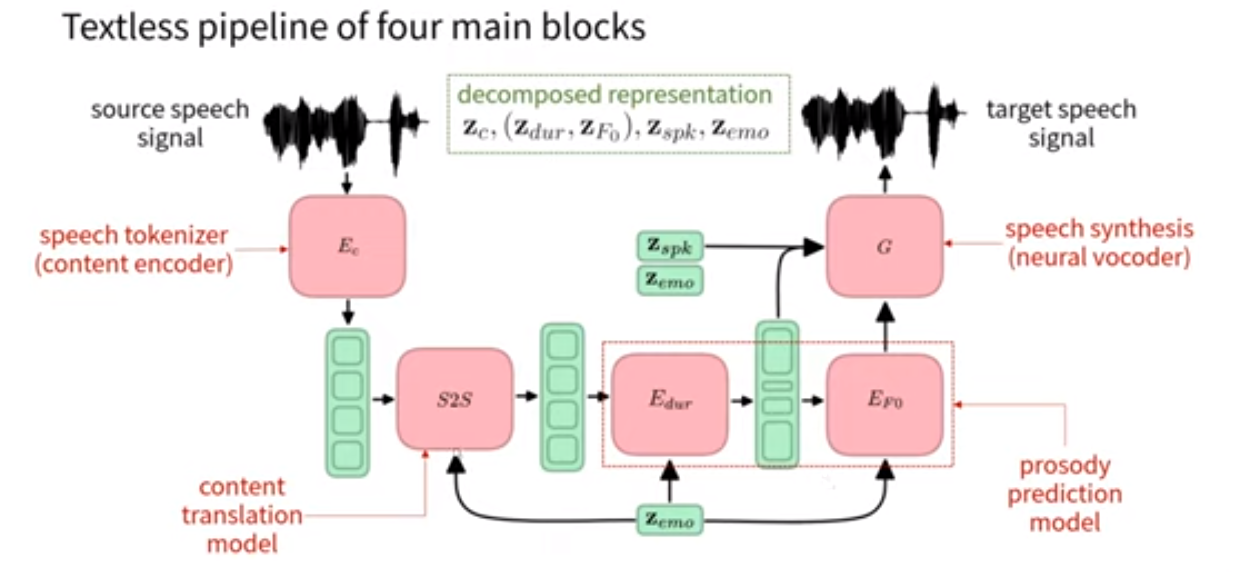

2.PR-380: Textless Speech Emotion Conversion using Discrete and Decomposed Representations

task는 gt로 prompt를 주면 이어서 자연스럽게 AI가 생성, 비언어적 표현, 웃음소리도 포함해서textless nlp : 장점으로는 발화자의 감정 실림(비언어적 요소)GSLM : 발화 encoder : contrastive learning, HuBERT(dee

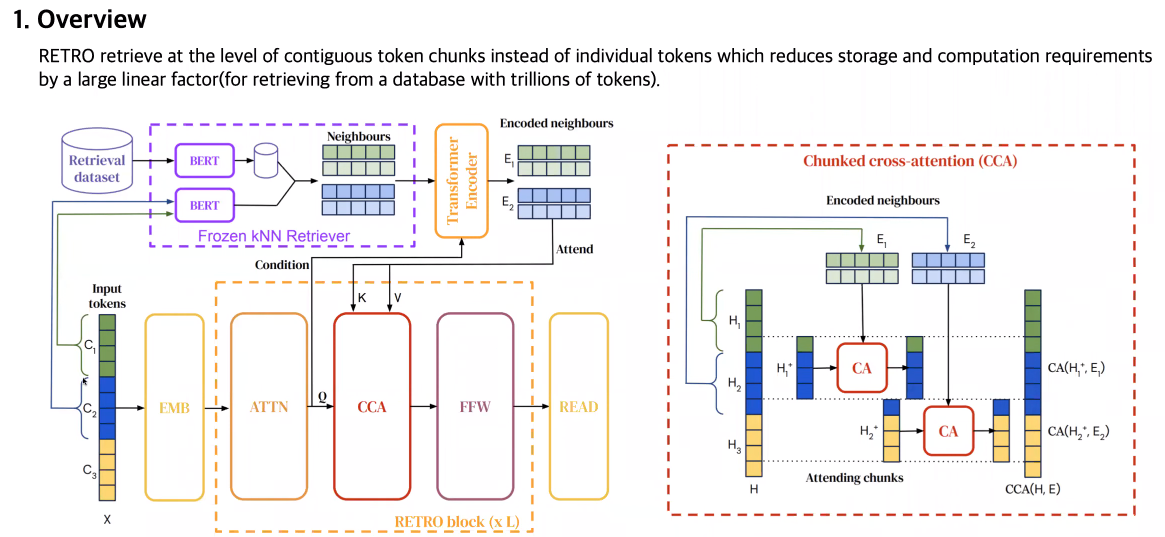

3.PR-379: Improving language models by retrieving from trillions of tokens

이 논문은 open ai에서 나온 논문이고, RETRO를 제안한 논문입니다.large data 기반으로 학습하여 performance를 높인 연구가 많다본 논문은 computation resource를 증가시키지 않으면서기존 DB의 retrieval을 통해 massiv

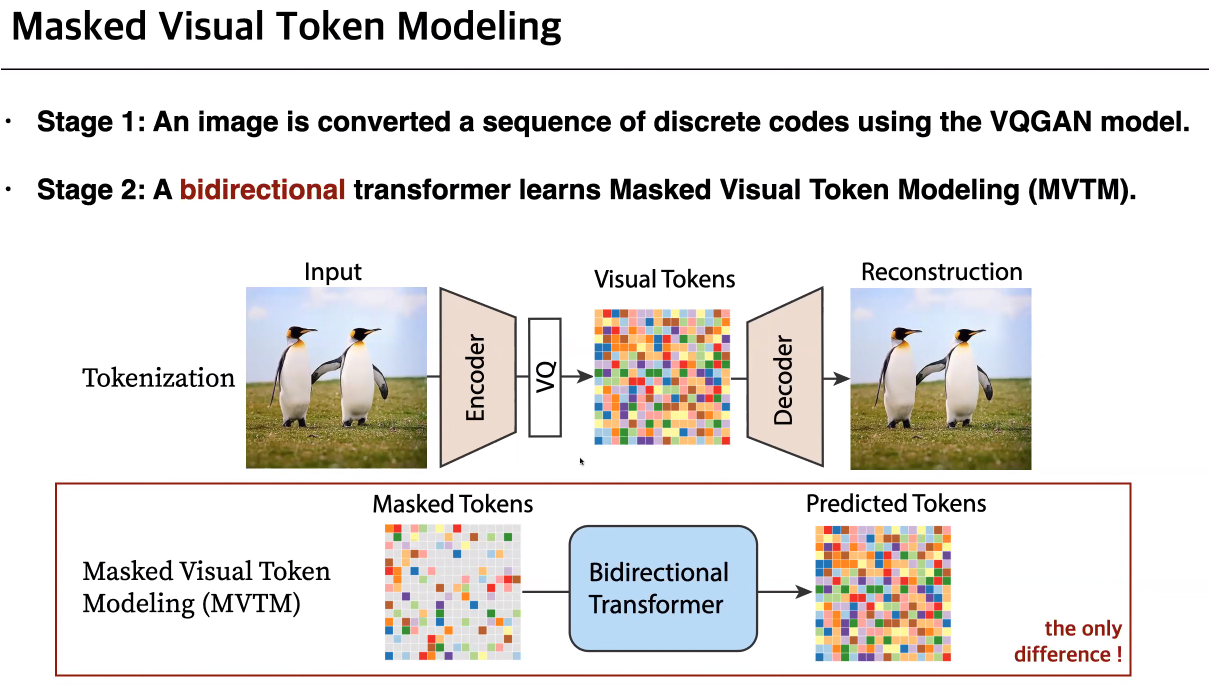

4.PR-375: MaskGIT: Masked Generative Image Transformer

GANs 장점 : high-fidelity, sampling speed 빠름, 고품질단점 : 학습 불안정, 이미지의 다양성이 부족Autoregressive장점 : explicit하게 estimation, 복잡한 분포도 학습 가능, 안정적, large scalestage

5.PR-384: Retrieval-Augmented Diffusion Models

Transformer: 복잡한 관계를 효과적으로 모델링Diffusion: Auto-regression을 넘어서 Likelihood estimation을 할 때도 사용Scale of Model, Datasetparameter를 늘리는 것 외에도 external memor

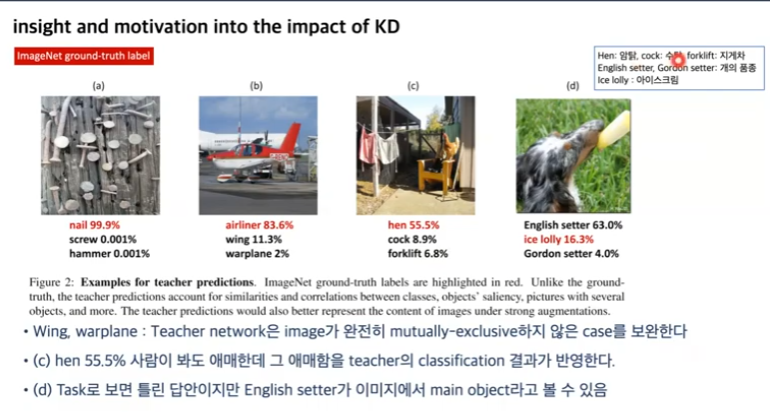

6.PR-383: Solving ImageNet: a Unified Scheme for Training any Backbone to Top Results

ImageNet SOTA는 Meta Pseudo label 최근 연구: 큰 데이터셋, ResNet CNN구조 재조명, 새로운 training scheme, 모델 구조 Regularization Aug: randAugment, AutoAugment Image: